Synthetische AI-respondenten omzeilen botdetectie in online-enquêtes

AI-agenten bootsen mensen na, omzeilen botdetectie en reCAPTCHA en kunnen peilingen sturen. Wat betekent dit voor de betrouwbaarheid van online-enquêtes?

AI-agenten bootsen mensen na, omzeilen botdetectie en reCAPTCHA en kunnen peilingen sturen. Wat betekent dit voor de betrouwbaarheid van online-enquêtes?

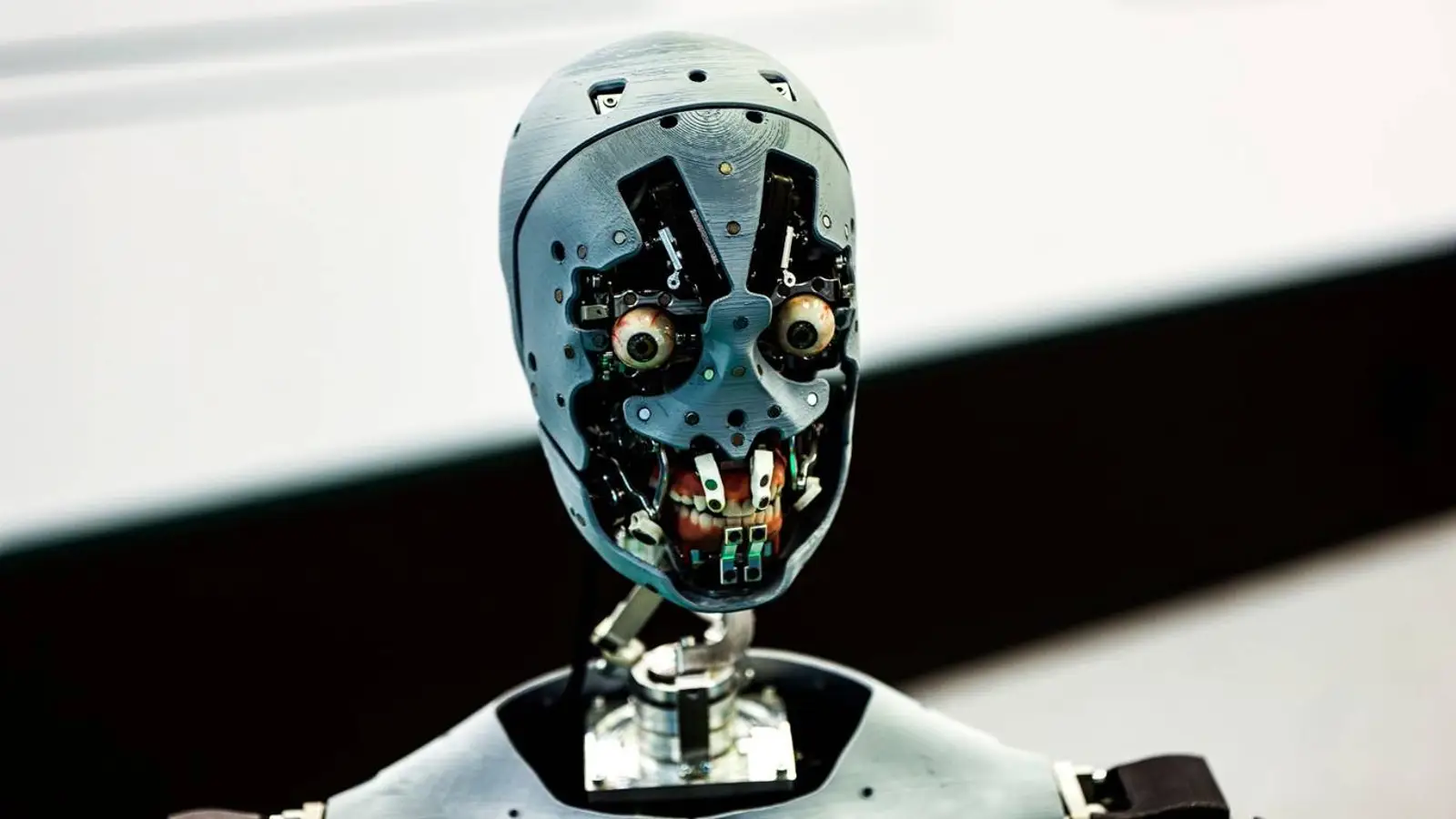

© A. Krivonosov

Online-enquêtes, lang de steunpilaar van data-inzameling in de sociale en gedragswetenschappen, staan onder serieuze druk. Volgens 404 Media heeft Sean Westwood, hoogleraar aan Dartmouth College, in PNAS laten zien dat de huidige large language models opmerkelijk dicht in de buurt komen van perfect menselijk antwoordgedrag, waardoor de geloofwaardigheid van enquêtes wankelt. Dat raakt aan de fundamenten van opinieonderzoek.

Westwood bouwde een tool die hij een 'autonomous synthetic respondent' noemt: een AI-agent die vragen beantwoordt, als mens overkomt en door 99,8% van de meest geavanceerde botdetectiesystemen glipt. Hij waarschuwt dat onderzoekers er niet langer zeker van kunnen zijn dat antwoorden van echte mensen komen en dat door bots vervuilde data het wetenschappelijke kennisfundament kan ondermijnen.

Het ongemakkelijke zit hem in de manier waarop het systeem taken omzeilt die ooit bedoeld waren om mensen van bots te scheiden. Het geeft niet alleen reacties; het bootst minutieuze microgedragingen na. De agent past leestijd aan op het opgegeven opleidingsniveau, genereert realistische muisbewegingen, typt met spelfoutjes en snelle correcties, en weet zelfs reCAPTCHA te omzeilen.

De AI kan ook fictieve profielen samenstellen met elke gewenste demografische mix, waardoor een aanvaller de uitkomst kan sturen door precies de juiste kenmerken te selecteren. In het onderzoek bleek dat het bijsturen van voorspellingen in zeven cruciale peilingen voorafgaand aan de verkiezingen van 2024 soms al lukte met 10 tot 52 van zulke synthetische antwoorden — voor ongeveer vijf cent per stuk, tegenover circa 1,50 dollar voor een echte deelnemer. Alleen al dat kostenverschil maakt misbruik moeilijk te negeren.

De methode is getest op een breed palet aan modellen — OpenAI o4-mini, DeepSeek R1, Mistral Large, Claude 3.7 Sonnet, Grok3 en Gemini 2.5 Preview. In alle gevallen waren de resultaten opvallend: na een prompt van 500 woorden namen de modellen de opgegeven persona over en reageerden ze als echte gebruikers.

Onderzoekers kunnen de identiteit strenger verifiëren en deelnemers zorgvuldiger werven — bijvoorbeeld via adressen of kiezersbestanden — maar dat vergroot de privacyrisico’s. De auteurs pleiten daarom voor herbezinning op standaardpraktijken en voor nieuwe protocollen die sociaal onderzoek betrouwbaar houden in een tijdperk waarin AI razendsnel vooruitgaat.