När AI blir enkätrespondent: bottar som hotar forskningsdata

En ny studie visar att stora språkmodeller kan efterlikna mänskliga enkätsvar, runda bottdetektering och snedvrida valmätningar. Läs om risker och skydd.

En ny studie visar att stora språkmodeller kan efterlikna mänskliga enkätsvar, runda bottdetektering och snedvrida valmätningar. Läs om risker och skydd.

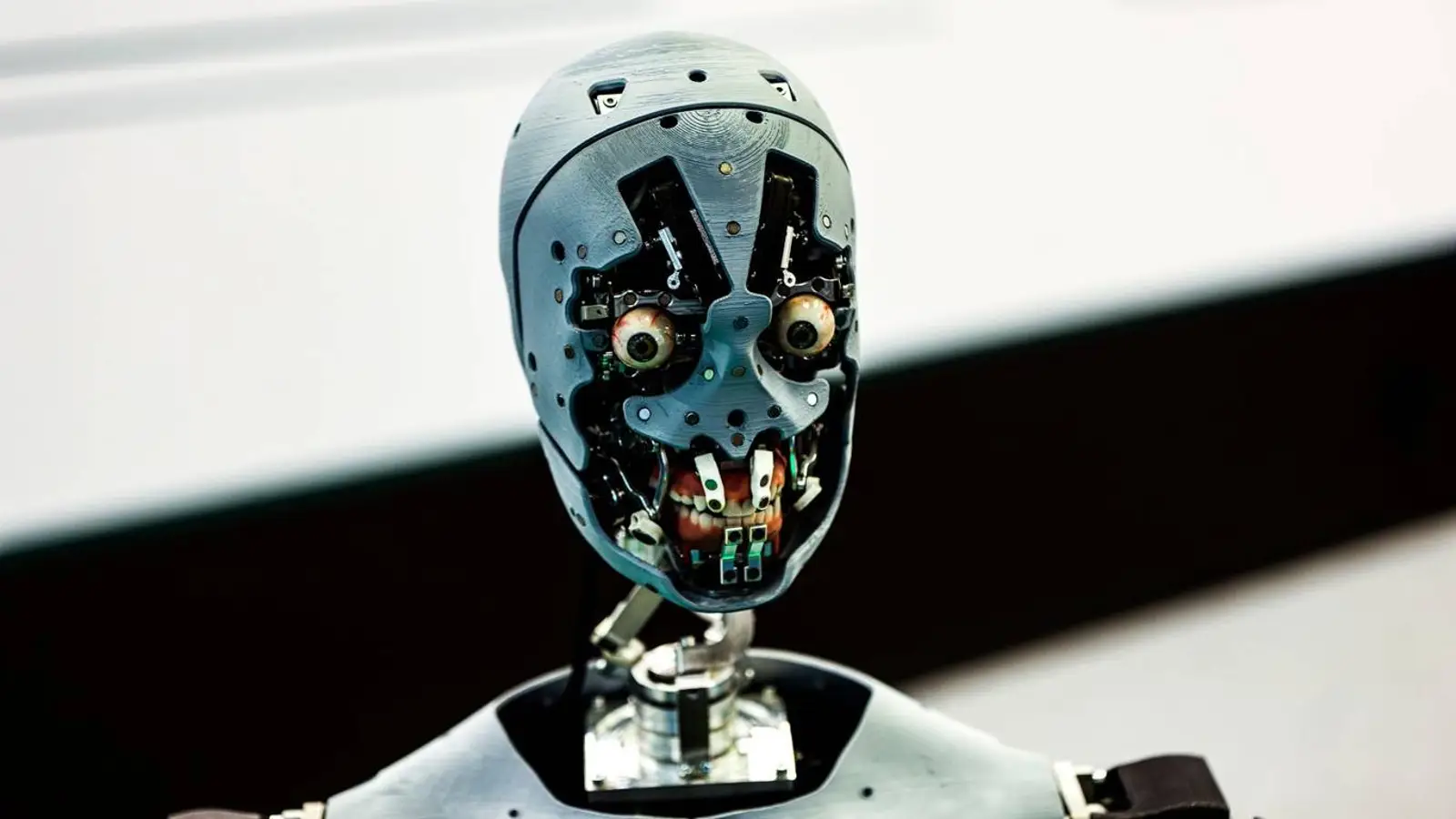

© A. Krivonosov

Nätbaserade enkäter har länge varit ryggraden i datainsamlingen inom samhälls- och beteendevetenskap, men står nu inför ett allvarligt hot. Enligt 404 Media har Sean Westwood, professor vid Dartmouth College, publicerat en studie i PNAS som visar att dagens stora språkmodeller kan komma obehagligt nära att perfekt efterlikna mänskliga svarspersoner, vilket sätter trovärdigheten för enkätresultat på spel.

Westwood har byggt ett verktyg som han kallar “autonomous synthetic respondent” – en AI-agent som besvarar frågor, passerar som människa och tar sig förbi 99,8 procent av de mest avancerade systemen för att upptäcka bottar. Han varnar för att forskare inte längre kan vara säkra på att svar verkligen kommer från människor och säger att botdriven datakontaminering kan undergräva den vetenskapliga kunskapsbasen. Det är en varningssignal som är svår att vifta bort.

Det som gör detta extra oroande är hur systemet tar sig an sådant som tidigare skilde människor från bottar. Det stannar inte vid att svara, utan speglar mänskliga mikrobeteenden i detalj: agenten anpassar lästiden efter den uppgivna utbildningsnivån, producerar realistiska musrörelser, skriver med stavfel och spontana rättningar – och tar sig till och med runt reCAPTCHA. Detaljgraden känns närmast obehagligt övertygande.

AI:n kan dessutom skapa påhittade profiler med valfri demografisk mix, vilket gör det möjligt för en angripare att styra utfallet genom att välja önskade egenskaper. Studien visade att prognoser i sju centrala opinionsmätningar inför valet 2024 kunde vridas med så lite som 10 till 52 sådana syntetiska svar – för ungefär fem cent styck, jämfört med cirka 1,50 dollar för en verklig deltagare. Enbart kostnadsbilden gör risken för missbruk svår att bortse från.

Metoden testades över en bred uppsättning modeller – OpenAI o4-mini, DeepSeek R1, Mistral Large, Claude 3.7 Sonnet, Grok3 och Gemini 2.5 Preview. I samtliga fall var resultaten anmärkningsvärt effektiva: efter en prompt på 500 ord antog modellerna en specificerad persona och svarade som verkliga användare.

Forskare kan skärpa identitetskontrollen och luta sig mer mot striktare rekrytering – urval via adresser eller väljarregister, till exempel – men det ökar integritetsriskerna. Författarna uppmanar därför till en omprövning av standardpraxis och till att ta fram nya protokoll som kan hålla samhällsforskningen tillförlitlig i en tid då AI utvecklas snabbt.