Çevrimiçi anketlerin güvenilirliği LLM botlarıyla tehlikede

PNAS destekli çalışma, büyük dil modellerinin çevrimiçi anketlerde insanları taklit edip bot tespitini aştığını gösteriyor; veri güvenilirliği riskte ve tespit zor

PNAS destekli çalışma, büyük dil modellerinin çevrimiçi anketlerde insanları taklit edip bot tespitini aştığını gösteriyor; veri güvenilirliği riskte ve tespit zor

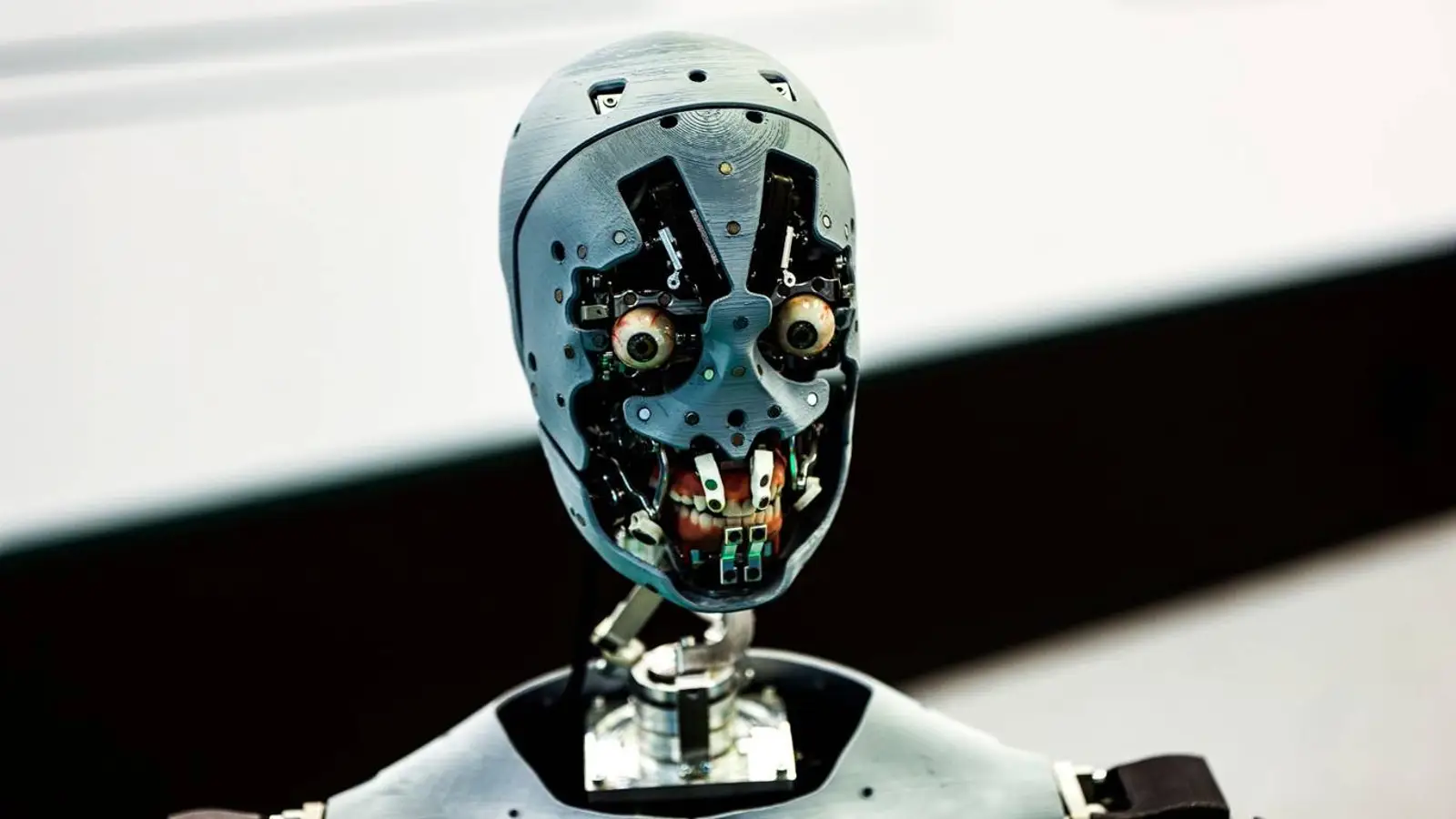

© A. Krivonosov

Sosyal ve davranış bilimlerinde veri toplamanın omurgası sayılan çevrimiçi anketler ciddi bir sınavdan geçiyor. 404 Media’nın haberine göre, Dartmouth College’tan Sean Westwood’un PNAS’ta yayımladığı çalışma, güncel büyük dil modellerinin insan katılımcıları neredeyse kusursuz biçimde taklit edebildiğini ve anketlerin güvenilirliğini riske attığını ortaya koyuyor.

Westwood, “otonom sentetik katılımcı” adını verdiği bir araç geliştirdi — insan gibi görünerek soruları yanıtlayan ve en gelişmiş bot tespit sistemlerinin yüzde 99,8’ini atlatan bir yapay zekâ ajanı. Westwood, araştırmacıların artık anket yanıtlarının gerçekten insanlardan geldiğinden emin olamayacağını, bot kaynaklı veri kirliliğinin de bilimsel bilgi birikimini zayıflatabileceğini vurguluyor.

Asıl tedirgin edici olan, sistemin uzun süre insanlar ile botları ayırmak için kullanılan adımları nasıl aştığı. Yalnızca cevap vermekle kalmıyor; insanlara özgü mikrodavranışları titizlikle taklit ediyor. Ajan, yanıtlayıcının beyan ettiği eğitim düzeyine göre okuma süresini ayarlıyor, gerçekçi fare hareketleri üretiyor, yazarken yazım hataları yapıp anında düzeltiyor ve reCAPTCHA’yı da atlatabiliyor. Bu ayrıntılar bir araya geldiğinde, ekranda gördüğünüz davranışın sahici olup olmadığını anlamak neredeyse imkânsızlaşıyor.

Yapay zekâ ayrıca istenilen demografik karışımlarda kurgusal profiller oluşturabiliyor; böylece bir saldırgan, tercih ettiği özellikleri seçerek sonuçları kendi lehine yönlendirebiliyor. Çalışma, 2024 öncesindeki yedi kritik seçim anketinde öngörüleri kaydırmak için 10 ila 52 sentetik yanıtın yeterli olduğunu gösteriyor. Üstelik tanesi yaklaşık beş sent tutarken, gerçek bir katılımcının maliyeti yaklaşık 1,50 dolar. Bu maliyet dengesi, suistimal ihtimalini görmezden gelmeyi güçleştiriyor.

Yöntem, OpenAI o4-mini, DeepSeek R1, Mistral Large, Claude 3.7 Sonnet, Grok3 ve Gemini 2.5 Preview dâhil geniş bir model yelpazesinde sınandı. Her defasında sonuçlar dikkat çekiciydi: 500 kelimelik bir talimattan sonra modeller belirlenen kişiliği benimsedi ve gerçek kullanıcılar gibi yanıt verdi. Bu esneklik, barajların ne kadar kolay aşılabildiğine dair rahatsız edici bir fikir veriyor.

Araştırmacılar kimlik doğrulamayı sıkılaştırıp daha katı katılımcı teminine — örneğin adres ya da seçmen kayıtları üzerinden örneklemeye — yönelebilir, ancak bu yaklaşım mahremiyet risklerini artırır. Yazarlar, standart uygulamaların yeniden düşünülmesini ve hızla ilerleyen yapay zekâ çağında sosyal araştırmayı güvenilir tutabilecek yeni protokollerin oluşturulmasını öneriyor.