Wie große Sprachmodelle Online-Umfragen aushebeln

PNAS-Studie: Große Sprachmodelle imitieren Befragte, umgehen Bot-Checks und verzerren Online-Umfragen. Schutzmaßnahmen – was Forschende jetzt tun sollten.

PNAS-Studie: Große Sprachmodelle imitieren Befragte, umgehen Bot-Checks und verzerren Online-Umfragen. Schutzmaßnahmen – was Forschende jetzt tun sollten.

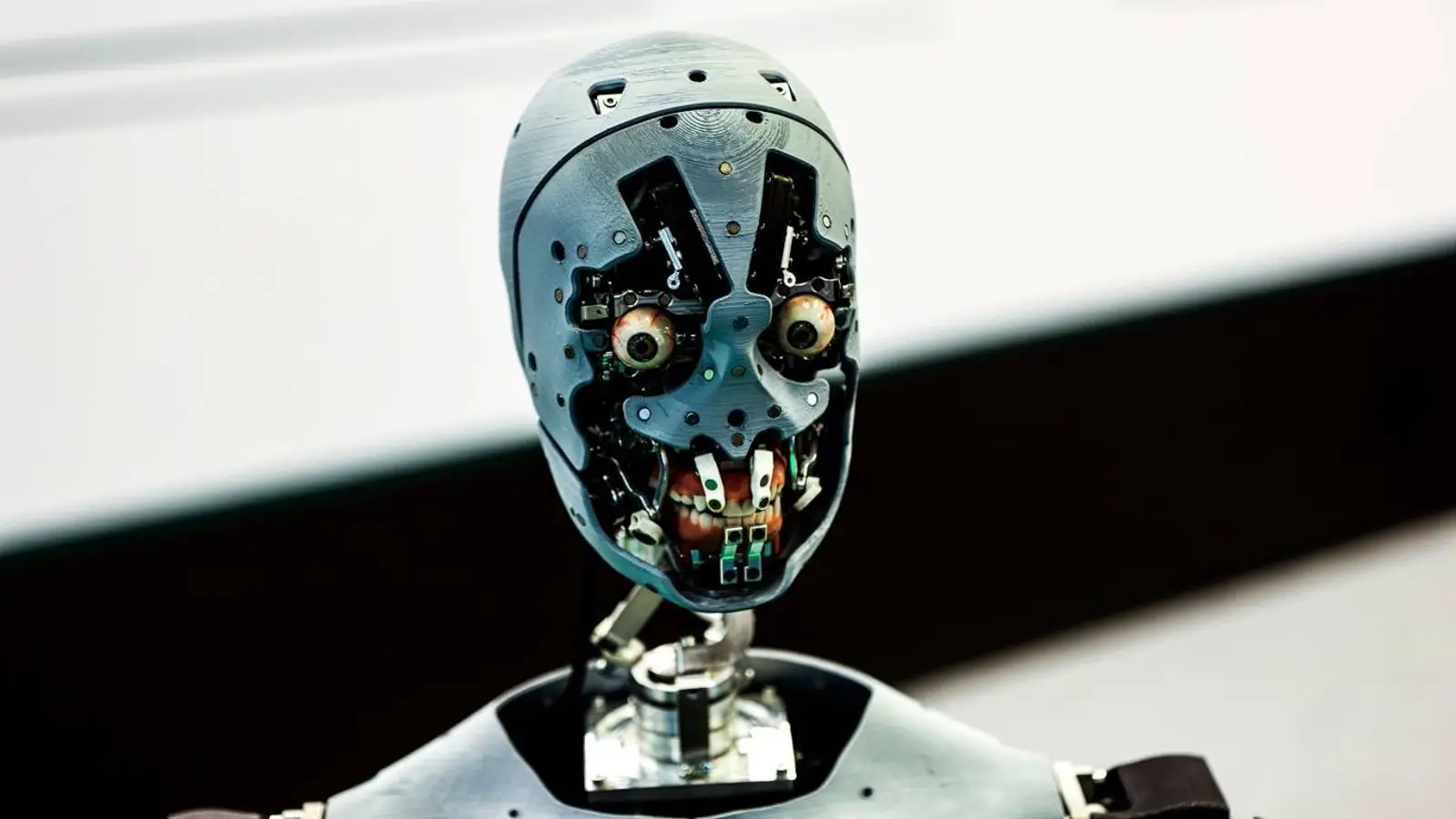

© A. Krivonosov

Online-Befragungen, lange das Rückgrat der Datenerhebung in der Sozial- und Verhaltensforschung, geraten unter Druck. Wie 404 Media berichtet, hat Sean Westwood, Professor am Dartmouth College, in PNAS eine Studie vorgelegt, die zeigt: Moderne große Sprachmodelle kommen einer perfekten Nachahmung menschlicher Teilnehmer erschreckend nah – mit Folgen für die Glaubwürdigkeit von Umfragen.

Westwood entwickelte ein Werkzeug, das er „autonome synthetische Auskunftsperson“ nennt – eine KI, die Fragen beantwortet, als wäre sie ein Mensch, und an 99,8 Prozent der fortgeschrittensten Bot-Erkennungssysteme vorbeikommt. Er warnt, Forschende könnten nicht mehr sicher sein, ob Antworten wirklich von Personen stammen, und verweist darauf, dass botgetriebene Verunreinigung die Wissensbasis der Wissenschaft unterminieren könnte. Das trifft einen Nerv: Wenn die Quelle wackelt, wackelt die Disziplin.

Besonders beunruhigend ist, wie souverän das System Prüfsteine umschifft, die bislang Menschen von Bots trennen sollten. Die KI liefert nicht nur Inhalte, sie imitiert mikroskopische Nutzerspuren mit Akribie: Sie passt die Lesezeit an das angegebene Bildungsniveau an, erzeugt realistische Mausbewegungen, tippt mit Tippfehlern und spontanen Korrekturen – und umgeht sogar reCAPTCHA. Wer so nah an Alltagsverhalten heranrückt, verwischt die Grenzlinie zur Authentizität.

Die Agenten können zudem beliebige demografische Profile aus dem Nichts erzeugen. Damit ließen sich Ergebnisse gezielt verschieben, indem die gewünschten Merkmale zusammengestellt werden. Die Studie zeigt, dass es in sieben zentralen Umfragen im Vorfeld der Wahlen 2024 teils bereits 10 bis 52 solcher synthetischen Antworten brauchte, um Prognosen zu verzerren – zu etwa fünf Cent pro Eintrag, während echte Teilnahmen rund 1,50 Dollar kosten. Allein diese Kostenrelation macht das Missbrauchspotenzial schwer wegzuwischen.

Getestet wurde der Ansatz quer durch die Modelllandschaft: OpenAI o4-mini, DeepSeek R1, Mistral Large, Claude 3.7 Sonnet, Grok3 und Gemini 2.5 Preview. In allen Fällen waren die Resultate deutlich: Nach einem Prompt von 500 Wörtern nahmen die Modelle die vorgegebene Persona an und antworteten wie echte Nutzerinnen und Nutzer. Das liest sich wie ein Härtetest, den die Systeme mit Leichtigkeit bestehen.

Als Gegenmittel kommen strengere Identitätsprüfungen und eine restriktivere Rekrutierung infrage – etwa Stichproben über Adressen oder Wählerverzeichnisse. Doch das erhöht die Risiken für den Datenschutz. Die Autorinnen und Autoren plädieren daher dafür, gängige Verfahren grundsätzlich zu überdenken und neue Protokolle zu entwickeln, die sozialwissenschaftliche Forschung auch im Tempo rasant voranschreitender KI verlässlich halten.