Comment des répondants synthétiques d’IA faussent les enquêtes en ligne

Des agents IA imitent des répondants humains et contournent les détecteurs, menaçant la fiabilité des enquêtes en ligne. Étude PNAS: coûts minimes, impact.

Des agents IA imitent des répondants humains et contournent les détecteurs, menaçant la fiabilité des enquêtes en ligne. Étude PNAS: coûts minimes, impact.

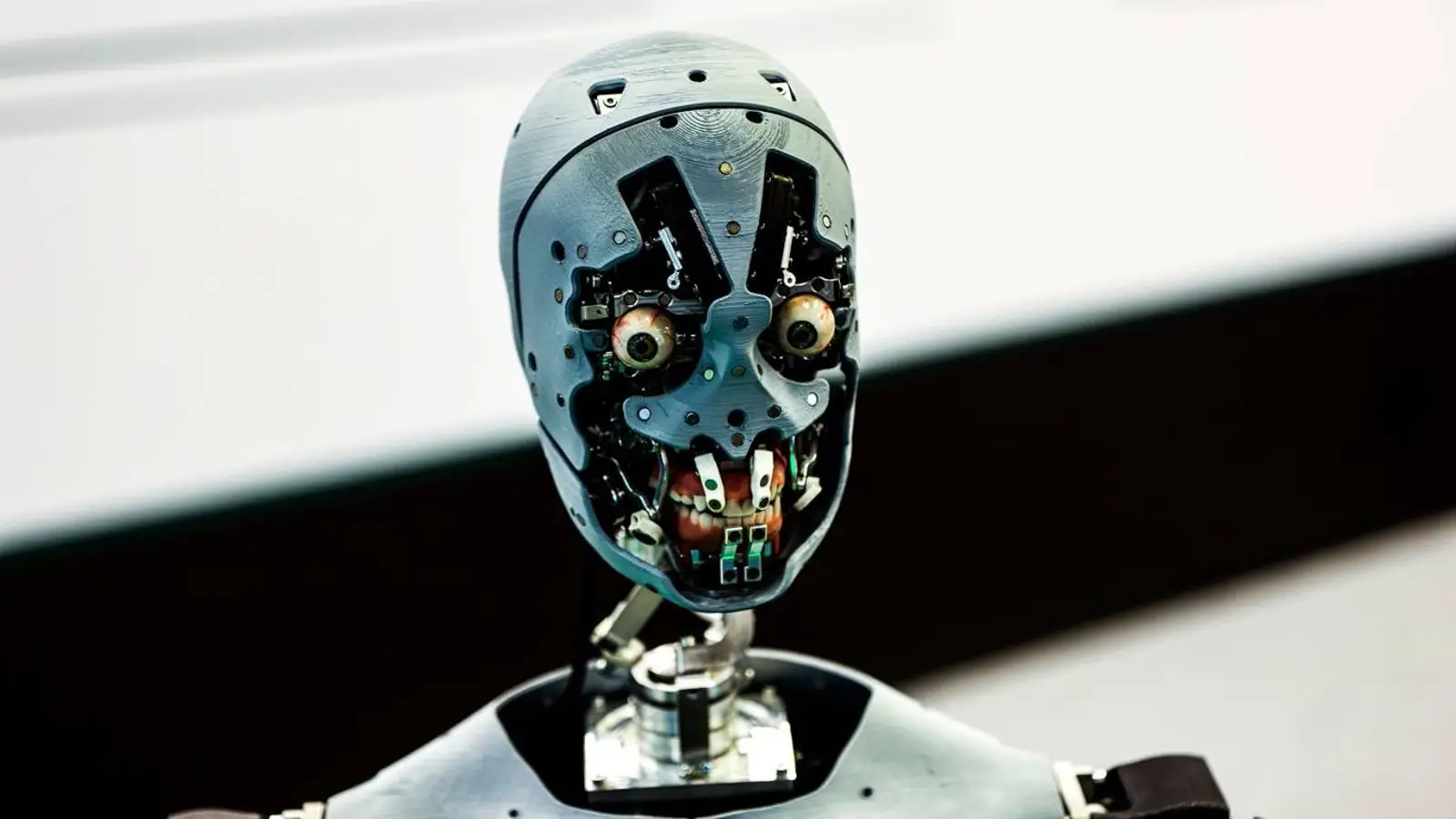

© A. Krivonosov

Les enquêtes en ligne, longtemps pilier de la collecte de données en sciences sociales et comportementales, traversent une zone de turbulence. Comme le rapporte 404 Media, Sean Westwood, professeur au Dartmouth College, a publié dans PNAS une étude montrant que les modèles de langage actuels peuvent imiter des répondants humains avec une précision troublante, au point d’ébranler la crédibilité des sondages.

Westwood a conçu un outil qu’il baptise « autonomous synthetic respondent » — un agent d’IA capable de répondre aux questionnaires en se faisant passer pour un humain, tout en déjouant 99,8 % des systèmes de détection de bots les plus évolués. Il avertit que les chercheurs ne peuvent plus garantir que les réponses proviennent de personnes réelles et estime que la contamination des données par des bots menace de saper le socle de connaissances scientifiques. Un signal qu’il serait imprudent d’ignorer.

Ce qui inquiète particulièrement, c’est la manière dont ce système se joue des tests autrefois conçus pour distinguer humains et automatismes. Il ne se contente pas de cocher des cases : il reproduit des microcomportements humains avec minutie. L’agent ajuste le temps de lecture au niveau d’études déclaré, génère des mouvements de souris crédibles, tape avec des fautes puis des corrections à la volée, et parvient même à contourner reCAPTCHA.

L’IA peut aussi créer des profils fictifs avec n’importe quel mélange démographique, laissant à un attaquant la possibilité d’orienter des résultats en choisissant les caractéristiques souhaitées. L’étude constate qu’il a suffi de 10 à 52 réponses synthétiques pour infléchir des prévisions dans sept sondages clés menés avant l’élection de 2024 — à environ cinq centimes de dollar la réponse, contre quelque 1,50 dollar pour un participant réel. Rien qu’à l’aune des coûts, l’incitation au détournement saute aux yeux.

La méthode a été éprouvée sur un large éventail de modèles — OpenAI o4-mini, DeepSeek R1, Mistral Large, Claude 3.7 Sonnet, Grok3 et Gemini 2.5 Preview. Dans tous les cas, l’efficacité a surpris : après une consigne de 500 mots, les modèles endossaient une persona spécifiée et répondaient comme de véritables utilisateurs.

Les chercheurs pourraient durcir la vérification d’identité et s’appuyer sur des modes de recrutement plus stricts — échantillonnage via adresses ou fichiers électoraux, par exemple —, au prix toutefois de risques accrus pour la vie privée. Les auteurs appellent à repenser les pratiques standard et à forger de nouveaux protocoles, capables de préserver la fiabilité de la recherche sociale à l’ère d’une IA qui progresse à grande vitesse.